黑马大数据学习笔记4-Hive部署和基本操作

目录

- 思考

- 规划

- 安装MySQL数据库

- 修改root用户密码

- 配置Hadoop

- 下载解压Hive

- 提供MySQL Driver包

- 配置Hive

- 初始化元数据库

- 启动Hive(使用Hadoop用户)

- Hive体验

- HiveServer2

- HiveServer2服务

- 启动

- Beeline

p48、51、52

https://www.bilibili.com/video/BV1WY4y197g7/?p=48

思考

Hive是分布式运行的框架还是单机运行的?

Hive是单机工具,只需要部署在一台服务器即可。

Hive虽然是单机的,但是它可以提交分布式运行的MapReduce程序运行。

规划

我们知道Hive是单机工具后,就需要准备一台服务器供Hive使用即可。

同时Hive需要使用元数据服务,即需要提供一个关系型数据库,我们也选择一台服务器安装关系型数据库即可。

所以:

服务 机器 Hive本体 部署在node1 元数据服务所需的关系型数据库(课程选择最为流行的MySQL) 部署在node1 为了简单起见,都安装到node1服务器上。

安装MySQL数据库

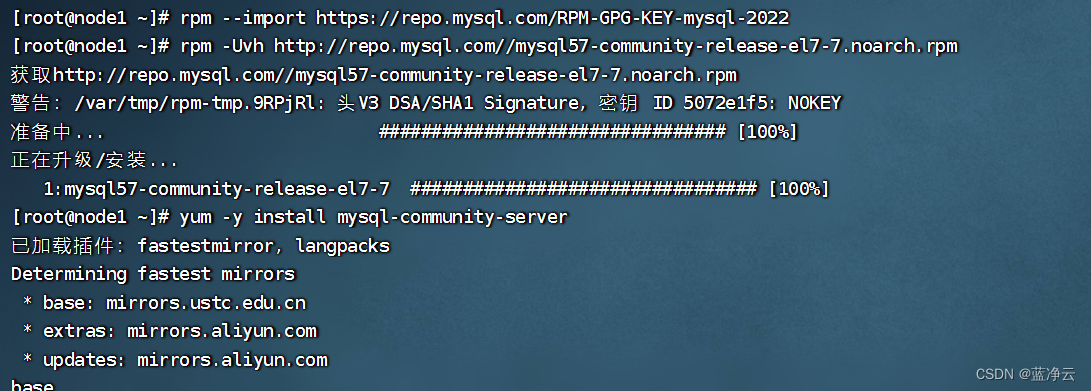

我们在node1节点使用yum在线安装MySQL5.7版本。

在root用户下执行

更新密钥

rpm --import https://repo.mysql.com/RPM-GPG-KEY-mysql-2022

安装Mysql yum库

rpm -Uvh http://repo.mysql.com//mysql57-community-release-el7-7.noarch.rpm

yum安装Mysql

yum -y install mysql-community-server

启动Mysql设置开机启动

systemctl start mysqld

systemctl enable mysqld

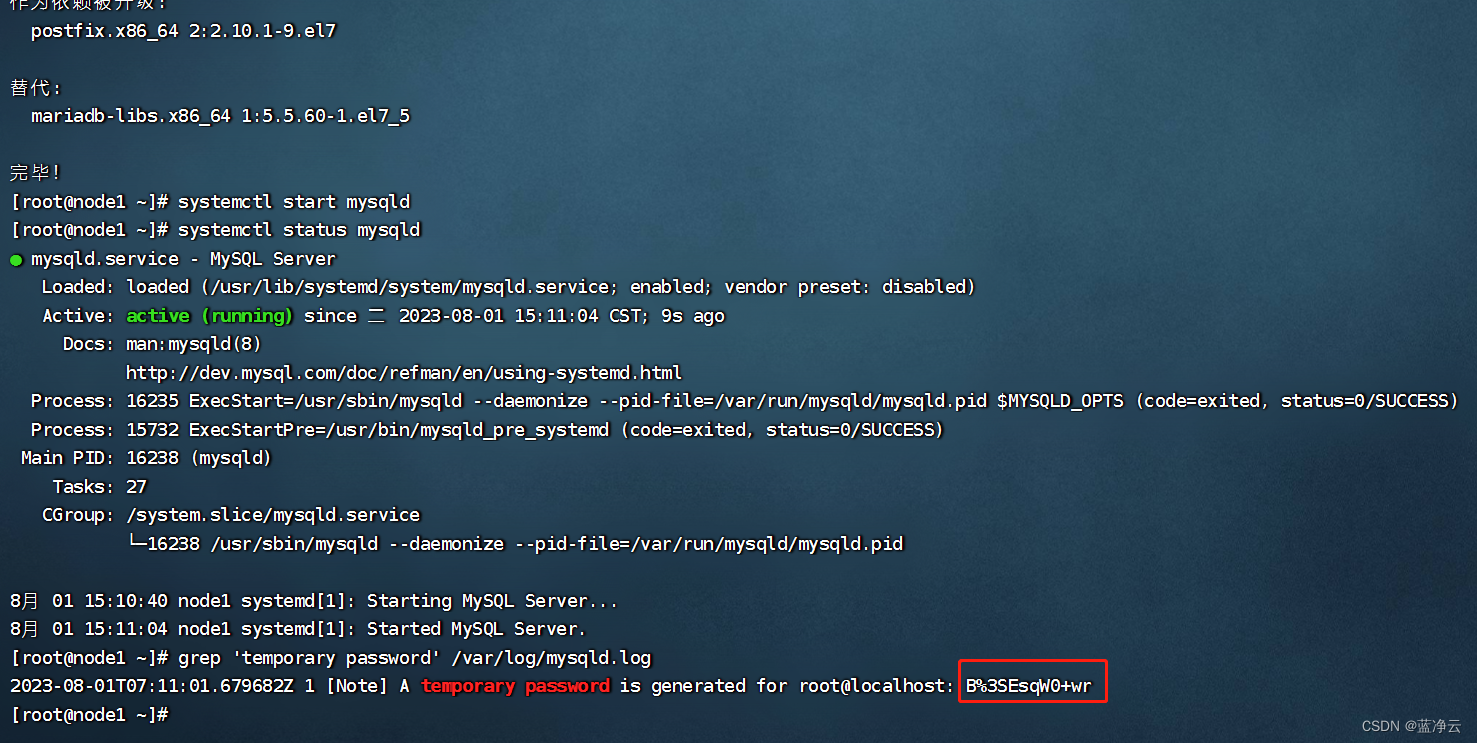

检查Mysql服务状态

systemctl status mysqld

第一次启动mysql,会在日志文件中生成root用户的一个随机密码,使用下面命令查看该密码

grep 'temporary password' /var/log/mysqld.log

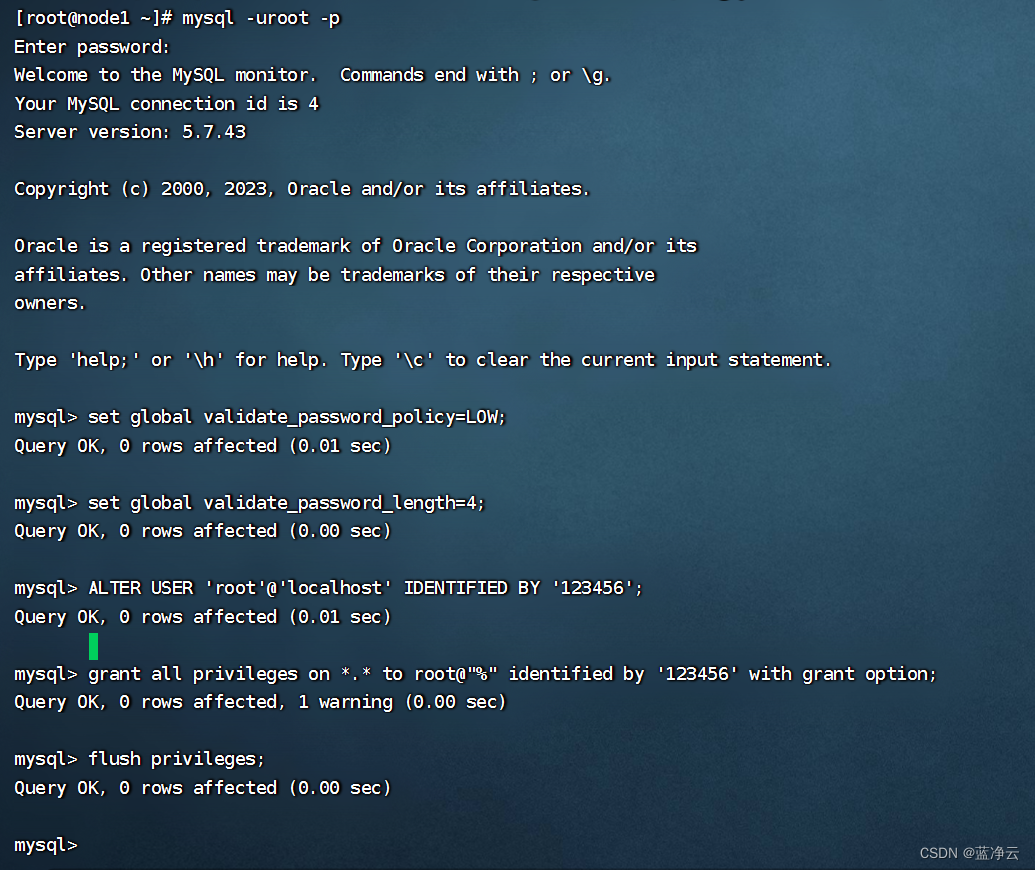

修改root用户密码

进入mysql

mysql -uroot -p

然后输入密码,回车。

如果你想设置简单密码,需要降低Mysql的密码安全级别

密码安全级别低

set global validate_password_policy=LOW;

密码长度最低4位即可

set global validate_password_length=4;

然后就可以用简单密码了(课程中使用简单密码,为了方便,生产中不要这样)

修改root本机登录密码为123456

ALTER USER 'root'@'localhost' IDENTIFIED BY '123456';

/usr/bin/mysqladmin -u root password ‘root’

修改远程登录密码,打开root用户从任意地方的主机远程登录的权限

grant all privileges on *.* to root@"%" identified by '123456' with grant option;

刷新权限

flush privileges;

ctrl+D退出mysql。

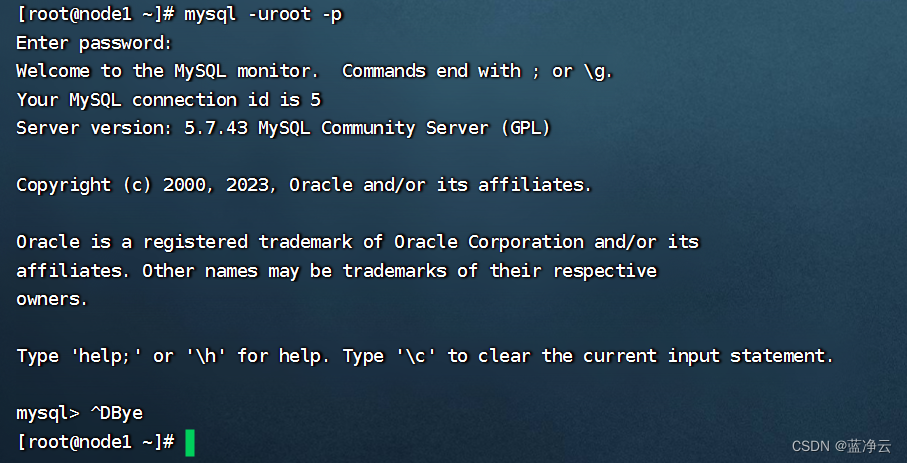

重新进入mysql验证密码是否修改完成。

mysql -uroot -p

配置Hadoop

Hive的运行依赖于Hadoop(HDFS、MapReduce、YARN都依赖)

同时涉及到HDFS文件系统的访问,所以需要配置Hadoop的代理用户

即设置hadoop用户允许代理(模拟)其它用户

切换到hadoop用户

su - hadoop

cd /export/server/hadoop/etc/hadoop/

vim core-site.xml

添加如下内容在Hadoop的core-site.xml的之间,并分发到其它节点,且重启HDFS集群。

hadoop.proxyuser.hadoop.hosts * hadoop.proxyuser.hadoop.groups *

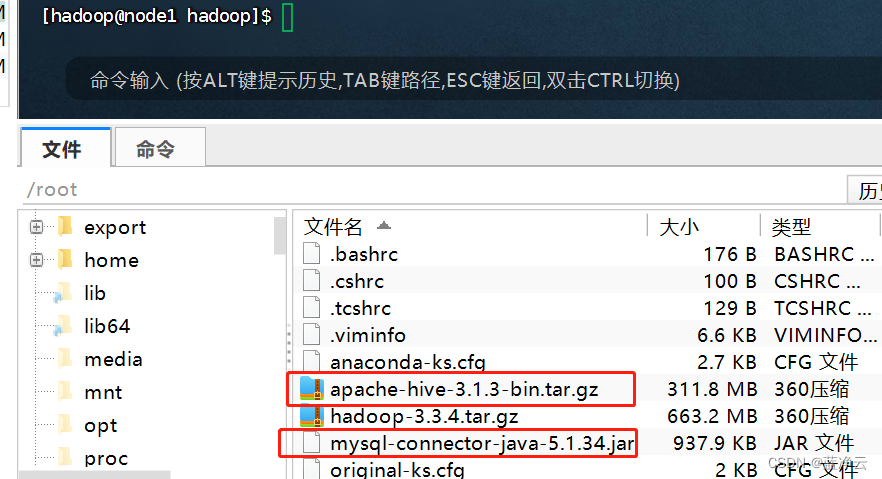

下载解压Hive

下载Hive安装包:

http://archive.apache.org/dist/hive/hive-3.1.3/apache-hive-3.1.3-bin.tar.gz

将下载好的文件拖拽上传

解压到node1服务器的:/export/server/内

tar -zxvf apache-hive-3.1.3-bin.tar.gz -C /export/server/

建立软链接

ln -s /export/server/apache-hive-3.1.3-bin /export/server/hive

提供MySQL Driver包

下载MySQL驱动包:

https://repo1.maven.org/maven2/mysql/mysql-connector-java/5.1.34/mysql-connector-java-5.1.34.jar

将下载好的驱动jar包,放入:Hive安装文件夹的lib目录内

mv mysql-connector-java-5.1.34.jar /export/server/apache-hive-3.1.3-bin/lib/

配置Hive

在Hive的conf目录内,新建hive-env.sh文件,填入以下环境变量内容:

cd /export/server/hive/conf

mv hive-env.sh.template hive-env.sh

vim hive-env.sh

export HADOOP_HOME=/export/server/hadoop export HIVE_CONF_DIR=/export/server/hive/conf export HIVE_AUX_JARS_PATH=/export/server/hive/lib

在Hive的conf目录内,新建hive-site.xml文件,填入以下内容:

vim hive-site.xml

javax.jdo.option.ConnectionURL jdbc:mysql://node1:3306/hive?createDatabaseIfNotExist=true&useSSL=false&useUnicode=true&characterEncoding=UTF-8 javax.jdo.option.ConnectionDriverName com.mysql.jdbc.Driver javax.jdo.option.ConnectionUserName root javax.jdo.option.ConnectionPassword 123456 hive.server2.thrift.bind.host node1 hive.metastore.uris thrift://node1:9083 hive.metastore.event.db.notification.api.auth false

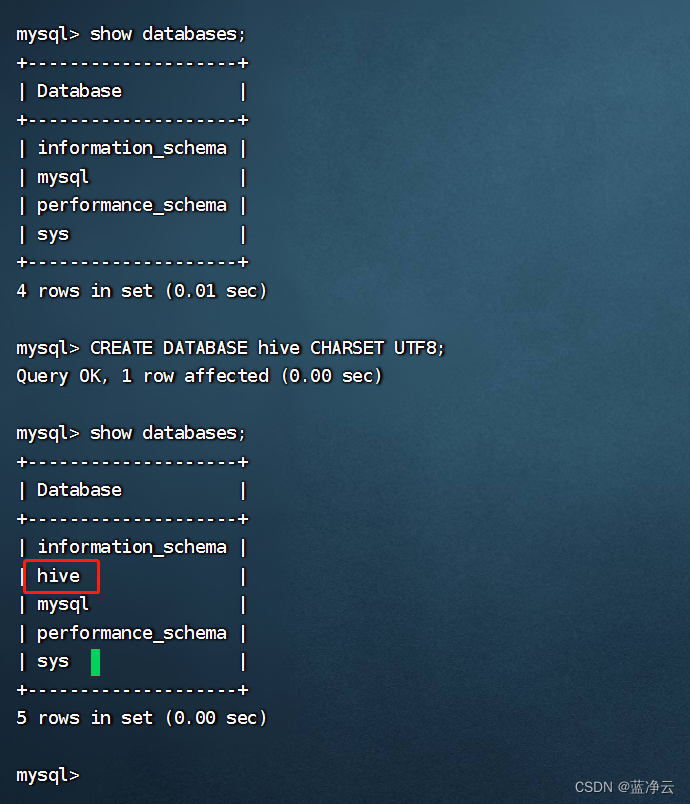

初始化元数据库

支持,Hive的配置已经完成,现在在启动Hive前,需要先初始化Hive所需的元数据库。

在MySQL中新建数据库:hive

mysql -uroot -p

show databases;

CREATE DATABASE hive CHARSET UTF8;

show databases;

退出mysql

exit

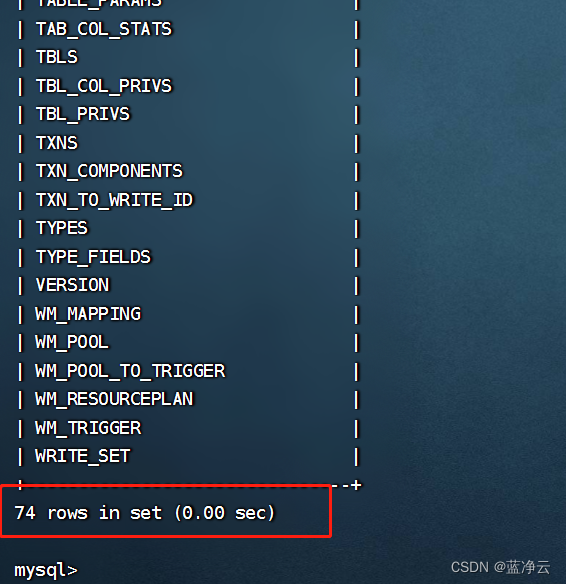

执行元数据库初始化命令:

cd /export/server/hive/bin

./schematool -initSchema -dbType mysql -verbos

初始化成功后,会在MySQL的hive库中新建74张元数据管理的表。

mysql -uroot -p

show databases;

use hive

show tables;

退出mysql

exit

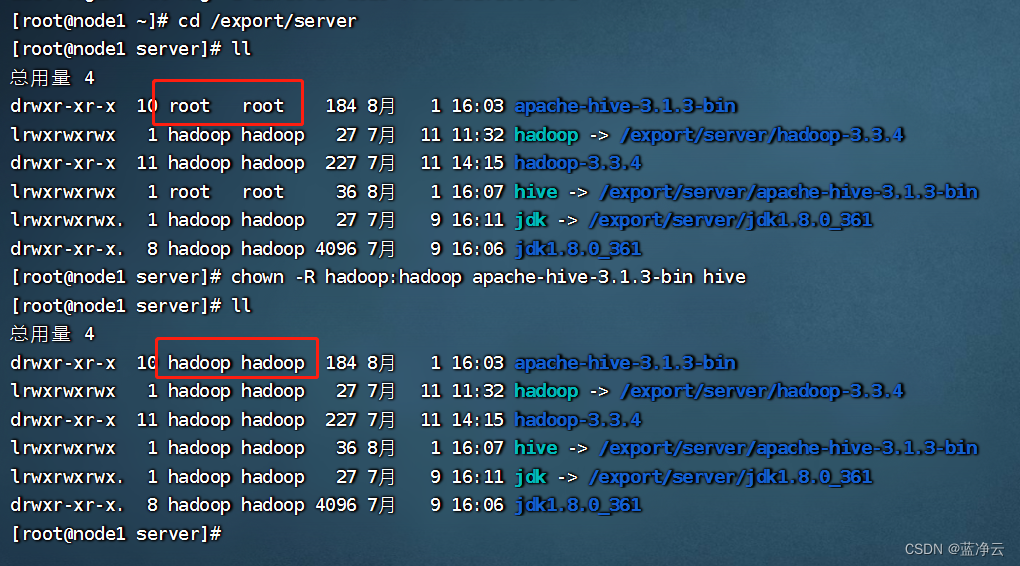

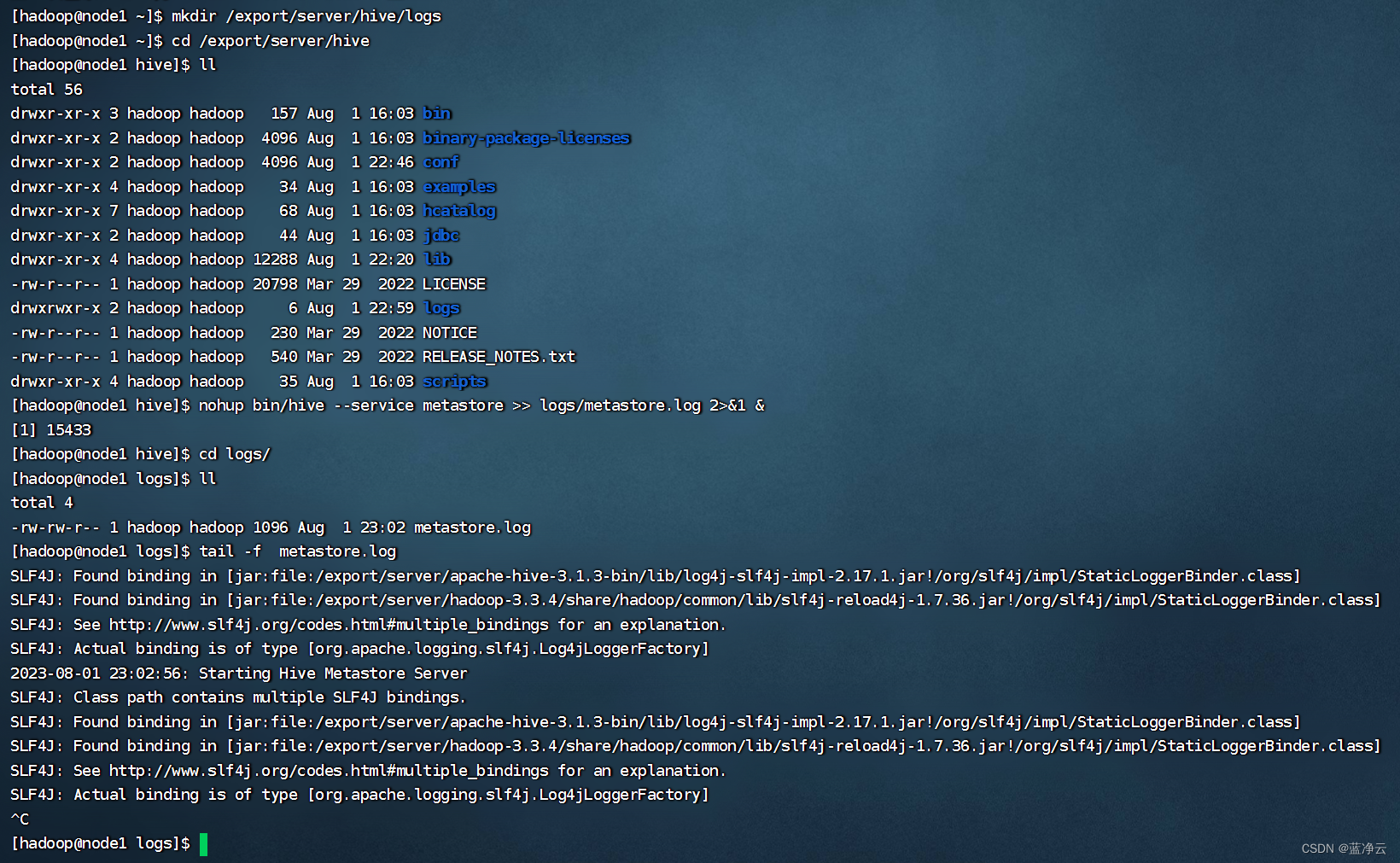

启动Hive(使用Hadoop用户)

修改文件权限

chown -R hadoop:hadoop apache-hive-3.1.3-bin hive

- 确保Hive文件夹所属为hadoop用户

- 创建一个hive的日志文件夹:

su - hadoop

mkdir /export/server/hive/logs

cd /export/server/hive

- 启动元数据管理服务(必须启动,否则无法工作)

前台启动:

bin/hive --service metastore

后台启动:

nohup bin/hive --service metastore >> logs/metastore.log 2>&1 &

查看日志

tail -f metastore.log

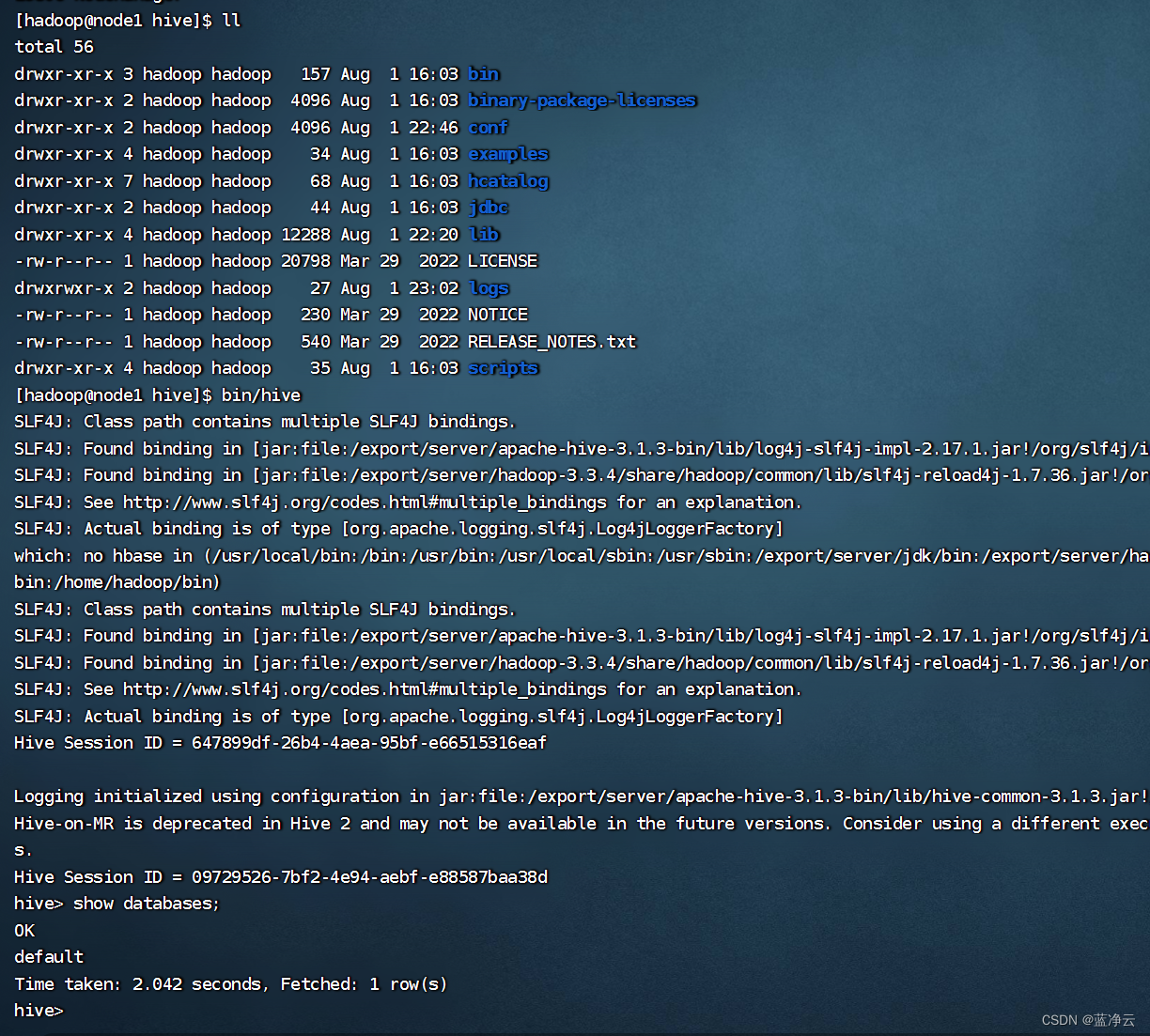

- 启动客户端,二选一(当前先选择Hive Shell方式)

确保metastore、hdfs和yarn都已经启动

Hive Shell方式(可以直接写SQL):

bin/hive

Hive ThriftServer方式(不可直接写SQL,需要外部客户端链接使用):

bin/hive --service hiveserver2

Hive体验

首先,确保启动了Metastore服务、hdfs和yarn集群。

start-dfs.sh

start-yarn.sh

mapred --daemon start historyserver

nohup /export/server/hive/bin/hive --service metastore >> /export/server/hive/logs/metastore.log 2>&1 &

可以执行:

cd /export/server/hive

bin/hive

进入到Hive Shell环境中,可以直接执行SQL语句。

创建表

CREATE TABLE test(id INT, name STRING, gender STRING);

show tables;

插入数据

insert into test values(1,'mm','nan');

INSERT INTO test VALUES(2,'王力红','男'),(3,'李华','女');

会执行得有点慢。。。

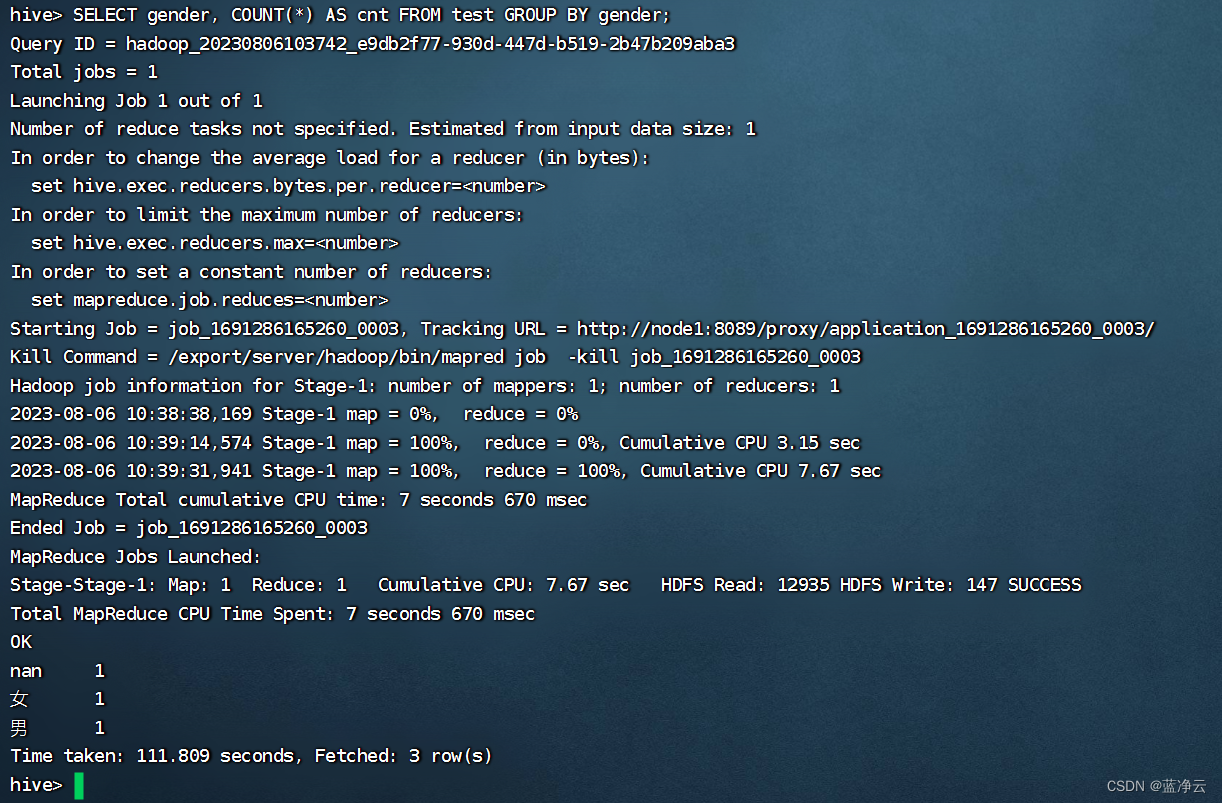

查询数据

SELECT gender, COUNT(*) AS cnt FROM test GROUP BY gender;

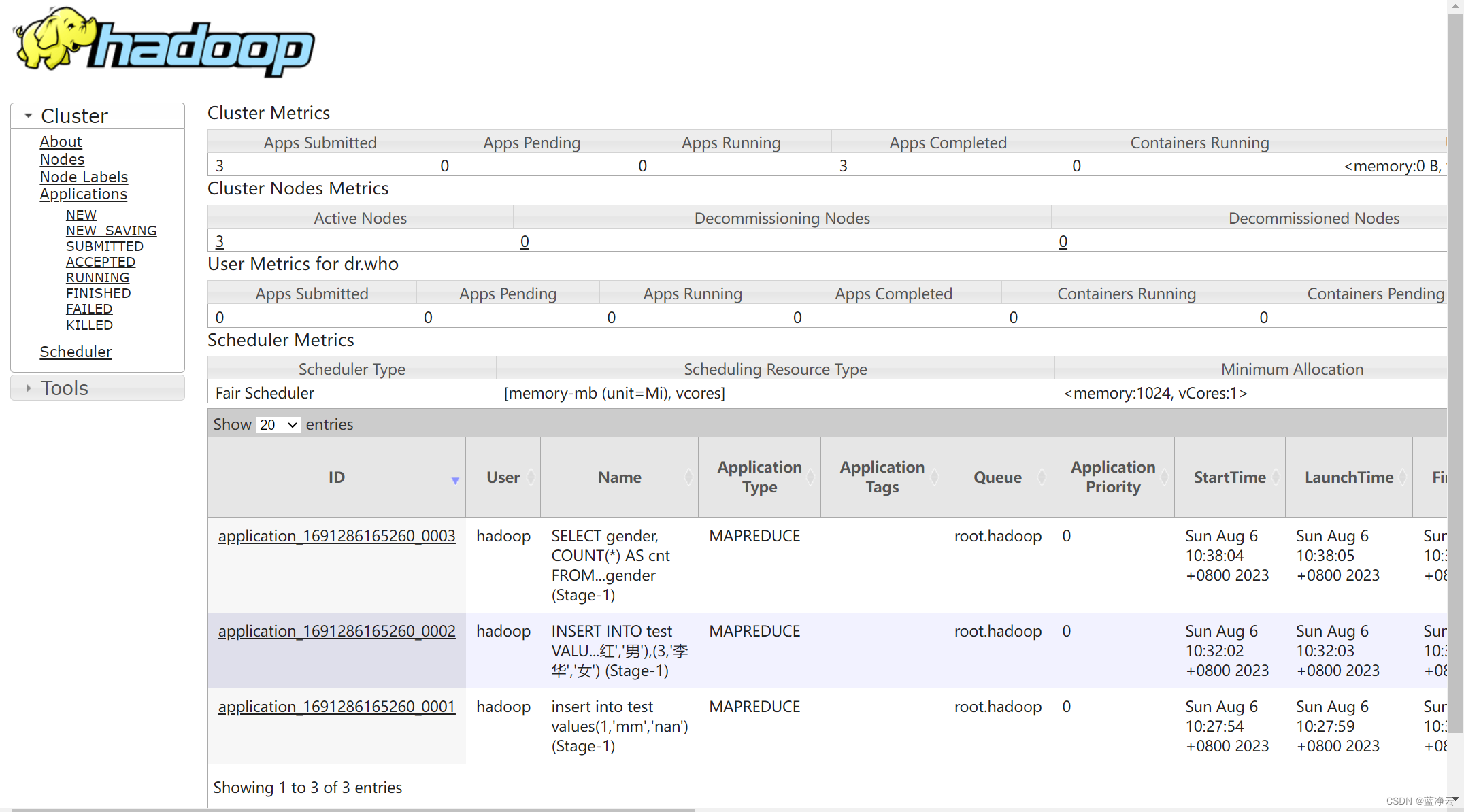

验证SQL语句启动的MapReduce程序

打开YARN的WEB UI页面查看任务情况:http://node1:8088

ctrl+c退出hive。

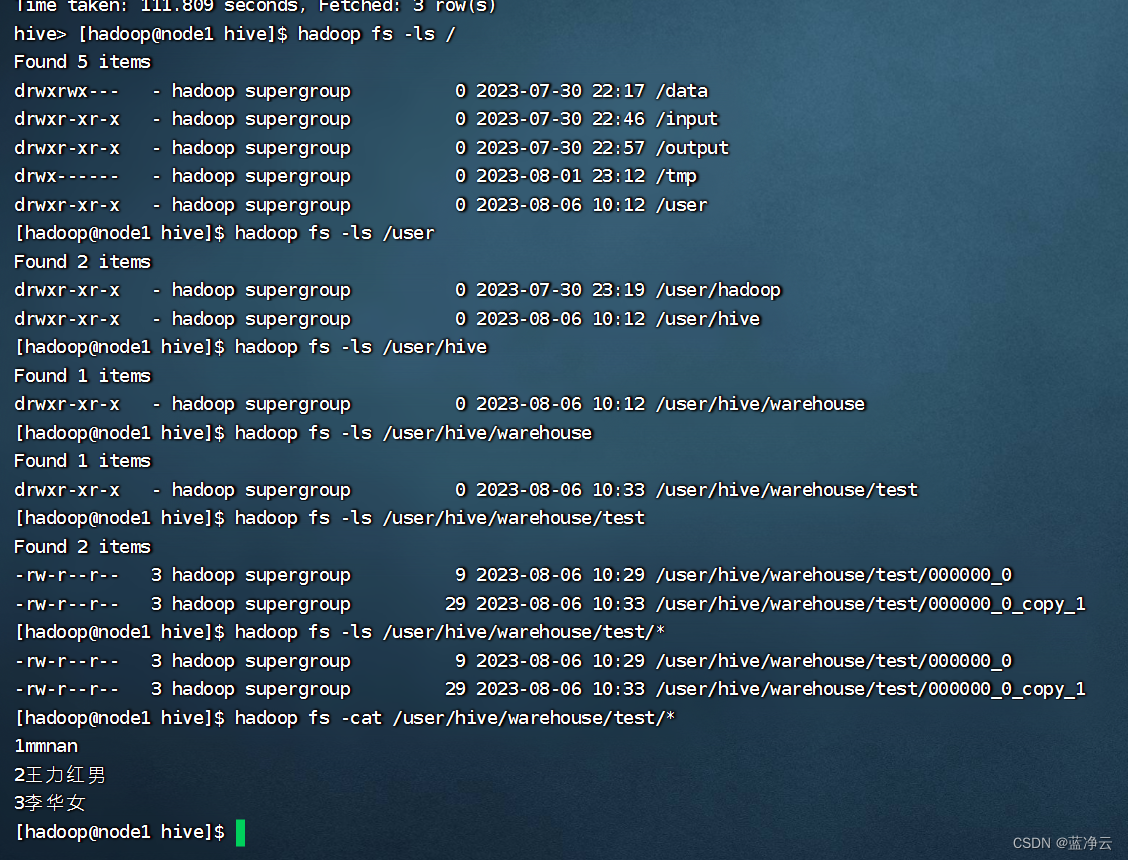

验证Hive的数据存储

Hive的数据存储在HDFS的:/user/hive/warehouse中

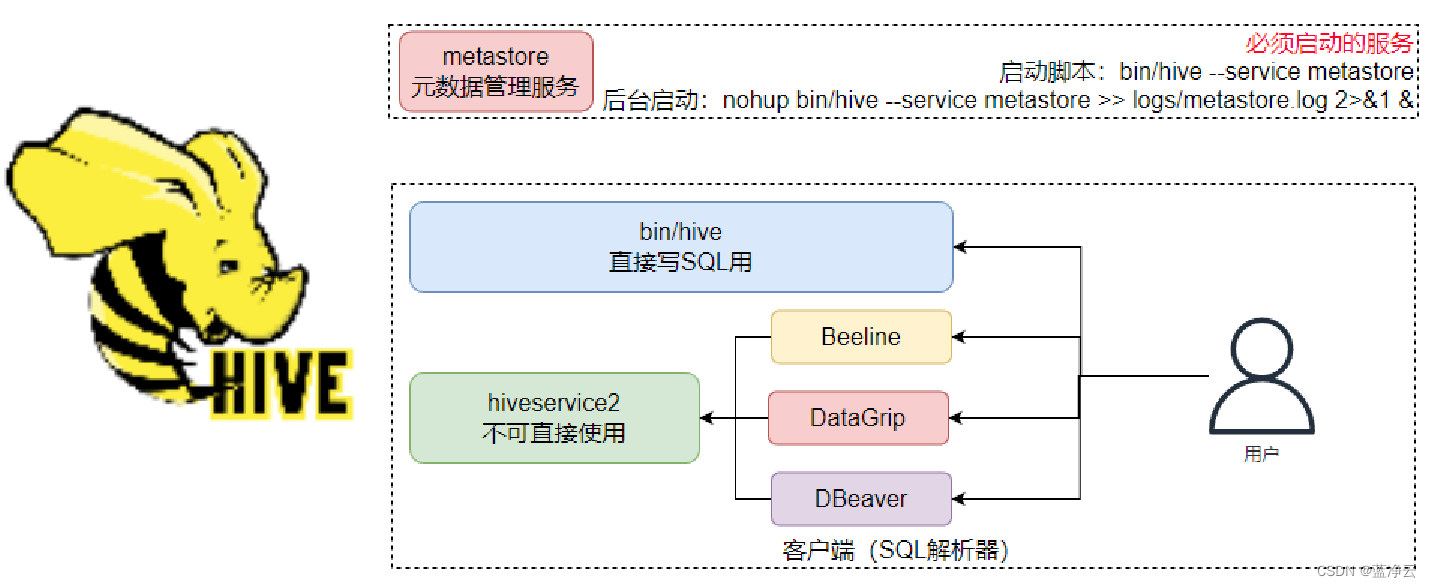

HiveServer2

在启动Hive的时候,除了必备的Metastore服务外,有2种方式使用Hive:

- 方式1:

bin/hive

即Hive的Shell客户端,可以直接写SQL

- 方式2:

bin/hive --service hiveserver2

后台执行脚本:

nohup bin/hive --service hiveserver2 >> logs/hiveserver2.log 2>&1 &

bin/hive --service metastore,启动的是元数据管理服务

bin/hive --service hiveserver2,启动的是HiveServer2服务

HiveServer2是Hive内置的一个ThriftServer服务,提供Thrift端口供其它客户端链接

可以连接ThriftServer的客户端有:

- Hive内置的 beeline客户端工具(命令行工具)

- 第三方的图形化SQL工具,如DataGrip、DBeaver、Navicat等

HiveServer2服务

Hive的客户端体系如下

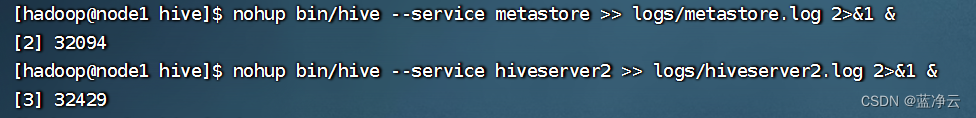

启动

在hive安装的服务器上,首先启动metastore服务,然后启动hiveserver2服务。

nohup bin/hive --service metastore >> logs/metastore.log 2>&1 &

nohup bin/hive --service hiveserver2 >> logs/hiveserver2.log 2>&1 &

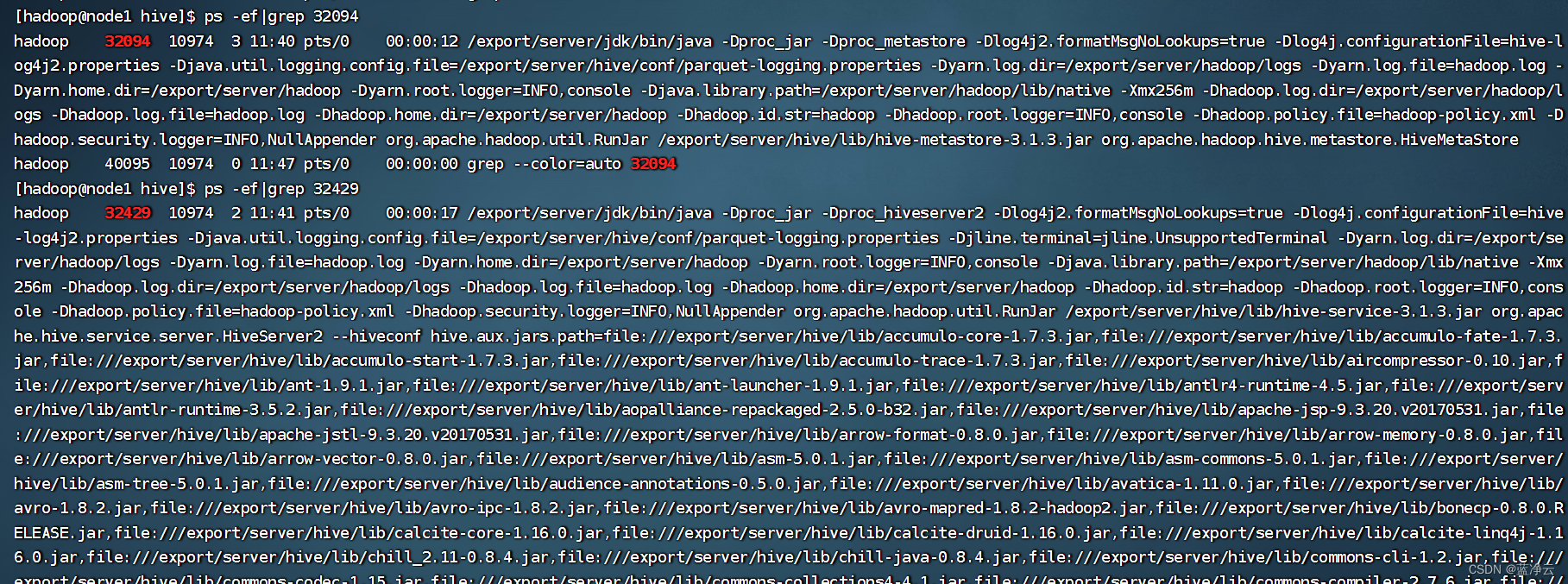

ps -ef|grep 32094

ps -ef|grep 32429

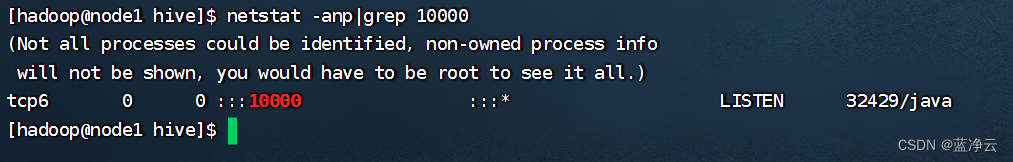

hiveserver2监听了10000端口,金对外提供的thrift端口,默认10000

netstat -anp|grep 10000

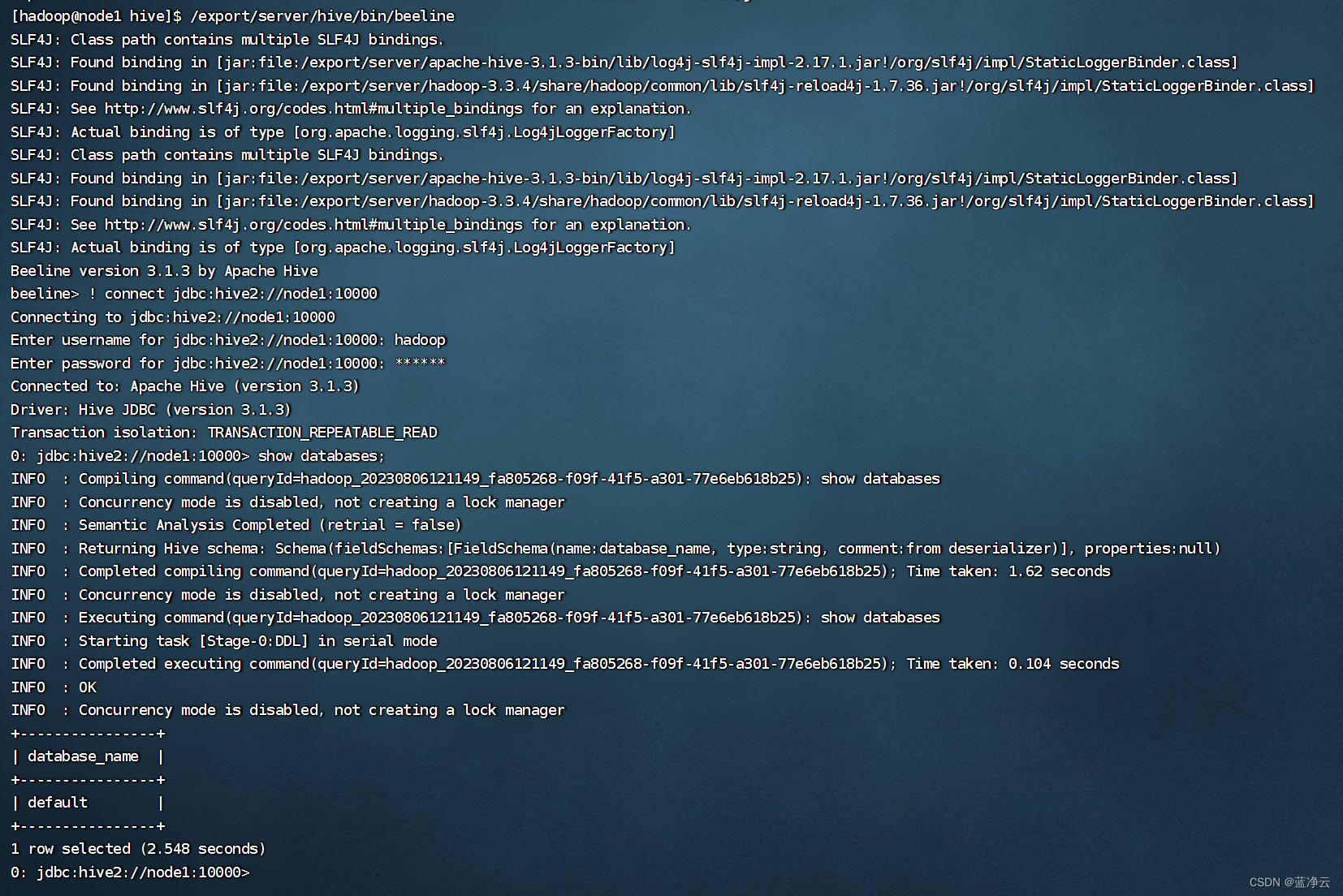

Beeline

在node1上使用beeline客户端进行连接访问。需要注意hiveserver2服务启动之后需要稍等一会才可以对外提供服务。

Beeline是JDBC的客户端,通过JDBC协议和Hiveserver2服务进行通信,协议的地址是:jdbc:hive2://node1:10000

/export/server/hive/bin/beeline

! connect jdbc:hive2://node1:10000

输入用户名和密码

show databases;

- 方式2:

- 方式1:

- 启动客户端,二选一(当前先选择Hive Shell方式)

- 启动元数据管理服务(必须启动,否则无法工作)

还没有评论,来说两句吧...